[2026 Predictions Webinar] How to Build an AI-Ready Data Architecture This Year | Register Now

Ermöglicht SIEM-Architects die Erweiterung und Optimierung von Cybersecurity-Lösungen

SIEM-Architects haben heute die Aufgabe, unterschiedliche Legacy-Cyber-Security-Lösungen in eine integrierte IT-Plattform umzuwandeln, die Sicherheitsdaten aus verschiedenen Quellen analysieren und darauf reagieren kann. Die Lösung von Confluent für Cybersicherheit erweitert vorhandene SIEM- und SOAR-Lösungen, um kontextreiche Daten zu liefern, die Threat Detection zu automatisieren und zu orchestrieren und False Positives zu reduzieren. Dies verändert die Art und Weise, wie Unternehmen Bedrohungen und Cyberangriffe in Echtzeit erkennen, analysieren und darauf reagieren, grundlegend.

Kunden-Erfolgsgeschichte

Intel entwickelt mit Confluent eine moderne, skalierbare Cyber-Intelligence-Plattform

„Cyberbedrohungen treten zunehmend häufiger auf und werden immer raffinierter. Unternehmen müssen sich rasch anpassen können, um diese Bedrohungen wirksam zu erkennen und abzuwehren und so ihre Umgebungen zu schützen. Hier bei Intel haben wir dieses Problem durch die Implementierung einer modernen, skalierbaren Cyber Intelligence Platform (CIP), die auf Splunk und Confluent basiert, gelöst. Wir glauben, dass diese CIP uns auch künftig eine optimale Verteidigung gegen Cyberbedrohungen ermöglichen wird.“

Brent Conran, Chief Information Security Officer

Den Wert der SIEM-Plattformen maximieren

SIEM wird von drei Faktoren bestimmt – Umfang, Geschwindigkeit und Kosten. Die zunehmende Vielfalt, die steigende Geschwindigkeit und das exponentiell wachsende Volumen von Sicherheitsdaten sind die Ursache dafür, dass veraltete SIEM-Technologien den aktuellen Anforderungen von Information Security(InfoSec)-Teams und Security Operations Centers (SOCs) nicht gewachsen sind. Den meisten Unternehmen wird nun bewusst, dass sie von SIEM-Anbietern unabhängiger werden und in der Lage sein müssen, mehrere Tools und analytische Ziele nutzen zu können.

Die beste Infrastruktur für das Echtzeit-Streaming von Daten wird mit den unternehmenseigenen Cybersicherheitsplattformen kombiniert, um Silos aufzubrechen sowie umfangreiche kontextbezogene Daten bereitzustellen und so situationsbewusster zu agieren. Mit Confluent profitieren Unternehmen von erstklassiger Dateneinspeisung, Echtzeit-Analysen sowie Kosten- und Skalierungsoptimierung.

So unterstützt Confluent bei der Optimierung des SIEM

Im Stream-Maßstab von Batch-Systemen zu Echtzeit-Daten wechseln

Dank einer Echtzeit-SIEM-Pipeline kann eine Cybersicherheitsdateninfrastruktur der nächsten Generation entworfen werden.

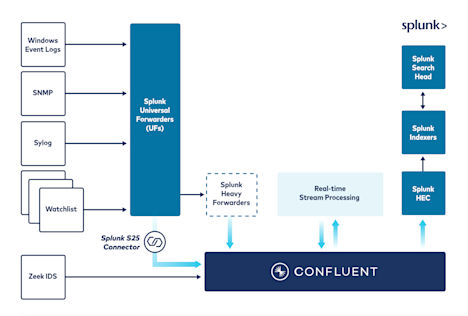

– Sicherheitsereignis- und Sensorendaten können mit mehr als 120 vorgefertigten Connectors wie Splunk, Elasticsearch, SNMP, Syslog, AWS Cloudwatch und mehr eingespeist, aggregiert und gespeichert werden. – Täglich können Billiarden von Nachrichten und Petabytes an Daten mühelos und innerhalb von Millisekunden verarbeitet werden.

Datenqualität verbessern und den Zeitbedarf für Bedrohungserkennung und -behebung reduzieren

Prozesse wie die Kuration, Anreicherung und Normalisierung von Daten ermöglichen Bedrohungserkennung und Data Engineering am Netzwerkrand oder am Erfassungspunkt für umfassende kontextbezogene Erkenntnisse.

– Die ausgefeilte Streamverarbeitung und Transformation von Einzelnachrichten ermöglichen eine umfassendere Erkennung von Bedrohungen und Anomalien. – Ungenaue Daten können durch die Unterdrückung und das Maskieren von Ereignissen, die nicht zur Erkennung und Untersuchung von Vorfällen beitragen, gefiltert werden. – Durch das Verschieben der Verarbeitung an den Netzwerkrand und den Erfassungspunkt wird die Latenz verringert, um rascher Erkenntnisse zu erhalten. – ML/KI-Modelle können rascher trainiert werden und sind so schneller bereit für die Produktion. Dies erweitert die Möglichkeiten der Bedrohungserkennung in Echtzeit.

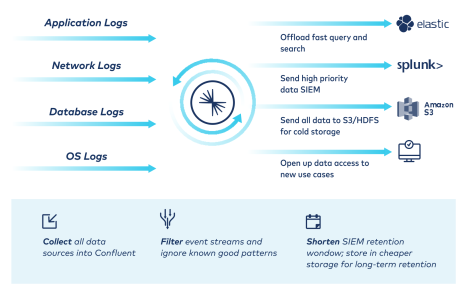

Datenindizierung, -analyse und Speicherkosten reduzieren

Die Auswirkungen steigender Datenspeicher- und Analysekosten, die Kompromisse bei Kosten, Flexibilität und Transparenz erzwingen, werden verringert.

– Das Einspeisungs- und Indizierungsvolumen sowie die Gesamtlizenzierungskosten im Zusammenhang mit verbrauchs- und volumenbasierter Abrechnung werden reduziert. – Der Bedarf für urheberrechtlich geschützte Weiterleitungen zur Senkung der Gesamtbetriebskosten wird gesenkt – mit Splunk S2S Connector. – Daten können zu kosteneffektiven Zielen mit Tiered Storage und Connectors zu Cloudspeicherinfrastrukturen wie Amazon S3, Google Cloud Storage, Azure Blob Storage, Snowflake und HBase weitergeleitet werden. – Daten können vor dem Exportieren aus dem Netzwerk und Importieren ins Netzwerk gefiltert und aggregiert werden, um Infrastruktur- und Cloudkosten zu senken.

Wahlfreiheit für Unternehmen

Confluent bietet ein völlig neues Maß an Flexibilität für Daten, unabhängig von Quelle oder Ziel – vollkommen anbieterunabhängig und als "Best of Breed"-Lösung. ⏎ – Die Datenportabilität wird erhöht, indem mühelos Daten aus jeder gewünschten Quelle, mit jedem gewünschten Ziel und in jeder gewünschten Umgebung integriert und geteilt werden können.– Der Wechsel von Legacy-SIEM-Tools zu innovativen Lösungen erfolgt nahtlos, ohne, dass man sich Sorgen über Datenverluste machen müsste. – Dank optimalen Tools wird für eine starke Cyber-Sicherheit und eine Demokratisierung des Datenzugangs gesorgt.

Vereinfachte Architektur und erweiterte Funktionen

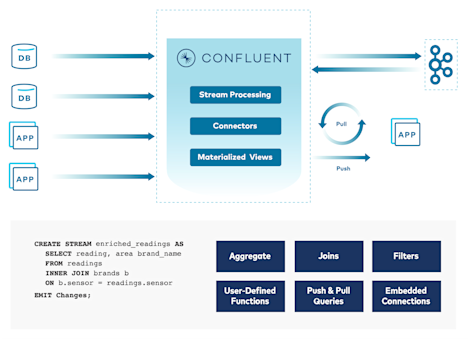

Breite Anbindung

Eine breite Palette an vorgefertigten Source- und Sink-Connectors ermöglicht ein müheloses Verbinden und Verschieben von Daten in gängigen Systemen.

Fortschrittliche Verarbeitung

Daten In-Stream umwandeln und anreichern durch die kontinuierliche Verarbeitung mit Apache Flink und Single Message Transform.

Unbegrenzte Aufbewahrung

Daten können über längere Zeiträume gespeichert werden, da manche Analyse-Tools Informationen zu Events bei unbegrenzter Speicherkapazität über mehrere Monate hinweg verarbeiten.

Branchenführende Sicherheit

Das Risiko von Sicherheitsverletzungen und Ausfallzeiten wird durch RBAC, Audit-Logs und Secret Protection minimiert.

Flexible Architektur

Eine zuverlässige Brücke gewährleistet Datenoperabilität in Echtzeit, ob vor Ort, in der Cloud oder am Netzwerkrand.

Zukunftssicheres Design

Dank einer flexiblen Architektur können neue Quellen oder Ziele durch die Entkopplung von Punkt-zu-Punkt-Integrationen integriert werden.

Überwachungslösungen auf Basis von Kafka

Datadog

Datadog nutzt Kafka als grundlegende Messaging-Technologie und erfasst Daten über Billionen von Datenpunkten pro Tag.MEHR ERFAHREN

New Relic

New Relic nutzt Kafka zum einfachen Aufbau von Echtzeit-Überwachungs- und Beobachtungspipelines mit Echtzeit-Warnungen.

SignalFX

SignalFX nutzt Kafka für moderne Überwachungs- und Analysefunktionen, die hunderttausende Messages pro Sekunde verarbeiten.

Honeycomb

Honeycomb verarbeitet mit Kafka große Mengen an Event-Traffic, da Nachrichten zwischen verteilten Systemen sicher veröffentlicht und konsumiert werden können.

Salesforce

Salesforce hat mit Kakfa eine gebrauchsfertige, event-getriebene Schicht für Liefer- und Bestellgarantien in einem sicheren, mandantenfähigen System gebaut.

Microsoft

Microsoft Azure verarbeitet bis zu 30 Millionen Ereignisse pro Sekunde und Billionen von Ereignissen pro Tag unter Verwendung von Kafka für Datenaufnahme und Streaming.

Weitere Ressourcen

Jetzt mehr darüber erfahren, wie die komplette, vollständig verwaltete Data-in-Motion-Plattform von Confluent die Art und Weise revolutioniert, wie Unternehmen Echtzeit-Datenmanagement, Einblicke, Analysen und SIEM umsetzen, um modernen Anforderungen gerecht zu werden.

Mehr über andere Lösungen von Confluent erfahren

Jetzt mehr darüber erfahren, wie die komplette, vollständig verwaltete Event-Streaming-Plattform von Confluent die Art und Weise revolutioniert, wie Unternehmen Echtzeit-Datenmanagement, Einblicke und Analysen in einer Vielzahl von Anwendungsfällen umsetzen.