[2026 Predictions Webinar] How to Build an AI-Ready Data Architecture This Year | Register Now

Messaging-Workloads modernisieren und über Queues und Pub/Sub hinausgehen

Eine moderne Messaging-Plattform kann den Echtzeit-Fluss von Daten erleichtern und für einen funktionierenden „Data in Motion“-Ansatz sorgen. Probleme, die sich aus der Datenkopplung und einer fehlenden skalierbaren Fehlertoleranz im Zusammenhang mit veralteter Messaging-Middleware ergeben, lassen sich vermeiden. Eine für die Cloud neu konzipierte, elastisch skalierbare und zukunftsfähige Plattform optimiert vorhandene Middleware.

Challenges with legacy middleware

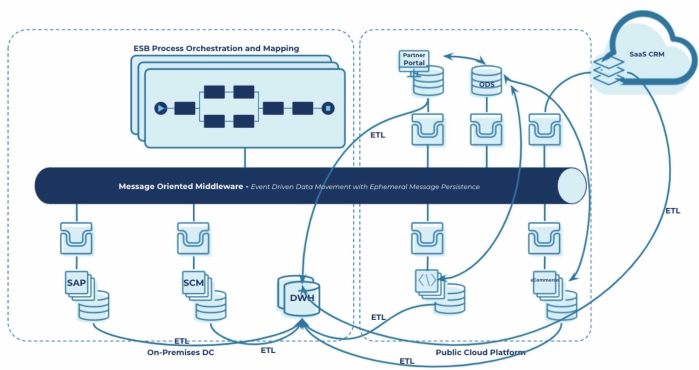

Traditional messaging systems like Message Queues (MQs), Enterprise Service Buses (ESBs), and Extract, Transform and Load (ETL) tools have been widely used for decades to handle message distribution and inter-service communication across distributed applications. However, they can no longer keep up with the needs of modern applications across hybrid and multi cloud environments for asynchronicity, heterogeneous datasets and high volume throughput.

Designed as monolithic systems, they are riddled with many challenges: they lack persistence or the ability to efficiently handle highly scalable, efficient and reliable message delivery. They don’t handle the real-time interactions and in-flight stream processing that modern applications demand.

This has left organizations with significant technical debt, demanding the need for a modern approach to messaging middleware.

So unterstützt Confluent

Confluent bietet eine auf Apache Kafka basierende, zukunftssichere Plattform, auf der über verschiedene Hybrid-Cloud- und Multi-Cloud-Umgebungen hinweg Daten gestreamt werden können. Diese Plattform ist nicht nur unbegrenzt skalierbar, sondern gleichzeitig auch ein dauerhaftes Aufzeichnungssystem. Betriebliche Komplexität kann mithilfe einer entkoppelten, event-getriebenen Infrastruktur beseitigt werden, so dass Entwickler sich dank des umfassenden Ökosystems aus Connectors und der ausgefeilten Möglichkeiten der Datenstromverarbeitung ganz auf die logischen Zusammenhänge innerhalb des Unternehmens konzentrieren können. Die Migration in eine cloud-zentrierte Architektur erfolgt so im gewünschten Tempo.

Erstellung einer modernen Infrastruktur

Die Transformation der eigenen Infrastruktur ermöglicht die Nutzung von Echtzeit-Workloads und ‑Anwendungen. Die "Time to Market" bei der Entwicklung von neuen Anwendungsfällen wird so von Monaten auf wenige Tage reduziert.Weshalb traditionelles Messaging nicht mehr das Nonplusultra ist

Jede Skalierung umsetzen

Die Erstellung einer zukunftssicheren Datenarchitektur sorgt für hohe Verfügbarkeit und Performance mit elastischer Skalierung. Unsere Kunden nutzen Confluent regelmäßig um mehr als 10 Billionen Nachrichten am Tag zu versenden.Confluent vs. traditionelle Middleware – ein Vergleich

Migration leicht gemacht

Durch die Erschließung von Legacy-Daten können neue Hybrid-Cloud- und Multi-Cloud-Anwendungsfälle erstellt sowie bestehende Messaging-Workloads auf einfache Weise und im gewünschten Tempo migriert werden.

Mehr über die Integration von Confluent mit Middleware erfahren

Warum Confluent

Echtzeit, Multi-Cloud Messaging in jeder Größenordnung.

Mit Confluent können heterogene Messaging-Systeme mit modernen Datenspeichern sowohl vor Ort als auch in der Cloud integriert werden. Messaging-Kapazitäten können unbegrenzt skaliert werden. Messaging-Systeme lassen sich mit der Data-in-Motion-Plattform von Confluent ganz einfach integrieren.

Einführung neuer Echtzeit-Anwendungen innerhalb weniger Tage dank nativer Streaming-APIs

Kafka-native Stream-APIs oder Flink eignen sich insbesondere für die Datenverarbeitung in Echtzeit, komplexe Event-Verarbeitung oder Anwendungen, die zustandsbehaftete Vorgänge und Windowing erfordern.

Entkopplung, Standardisierung und Verwaltung von Daten über alle Systeme hinweg

Schema Registry bietet eine einheitliche Methode zum Austausch von bereinigten und im Rahmen von Data Governance verwalteten Daten zwischen den Producers und Consumers. Das Teilen funktioniert selbst dann, wenn sich die jeweiligen Schemata im Laufe der Zeit weiterentwickeln. Zusätzlich erhalten Kunden Zugriff auf ein umfassendes Ökosystem bestehend aus über 120 Connectors, darunter IBM MQ, TIBCO, HiveMQ, RabbitMQ und ActiveMQ, sowie zu Consumer-Applikationen von Drittanbietern (Snowflake, MongoDB).

Erstellung von einem dauerhaften Aufzeichnungssystem, bei dem die erneute Wiedergabe innerhalb der Bestellung möglich ist, sowie Entwicklung von kontextabhängigen, statusbehafteten Anwendungen

Tiered Storage vereinfacht die Speicherung von riesigen Datenmengen in Kafka, indem betriebliche Belastung und Kosten reduziert werden. Mithilfe von Event-Sourcing können mühelos Materialized Views nachgebildet werden. Exactly-Once Semantics sorgen dafür, dass alle Nachrichten auch wirklich nur einmal versendet werden. Durch statusbehaftete Anwendungen können Leistungseinbußen aufgrund von zusätzlichen Datenbankabfragen verhindert werden.

Nutzung einer fehlertoleranten Plattform mit elastischer Skalierung

Cluster Linking gewährleistet die höchstmögliche Verfügbarkeit und Zuverlässigkeit für Daten-Backups über mehrere Zonen und Regionen hinweg. Das Confluent Control Center bietet Möglichkeiten zur Zustandsüberwachung von Clustern, Topics und Consumers. Dank rollenbasierter Zugriffskontrollen (Role-based Access Control, RBAC) besteht Skalierungspotenzial im Hinblick auf Multi-Tenancy-Architektur und unternehmensweite Anwendungen im Rahmen einer einheitlichen Infrastruktur.

Beseitigung von Verzögerungen und Ausfällen aufgrund von langsamen oder „Offline“-Consumers

Die Verwendung von Partitions für die Unterteilung nach Themen ermöglicht eine hohe Leistung und Persistenz in deterministischen Systemen. Self-Balancing-Cluster sowie Tiered Storage sorgen für einen vollautomatisierten Lastausgleich. Confluent for Kubernetes vereinfacht die Bereitstellung und den Betrieb durch die Anwendung unserer Best Practices für die Ausführung einer sicheren, zuverlässigen und produktionsreifen „Data in Motion“-Plattform.

Inkrementelle Modernisierung der Workloads sowie Reduzierung der Gesamtbetriebskosten und der betrieblichen Komplexität

Aufgrund der Unterstützung traditioneller Messaging-Muster (Punkt-zu-Punkt und Routing-Semantik für die Veröffentlichung/Abonnements) in Confluent kann die Migration ohne Betriebsunterbrechungen im gewünschten Tempo stattfinden. Ein umfassendes Connector-Ökosystem und Anwendungen, die über eine native Kafka-Integration verfügen, bieten zusätzliche Vorteile. Dank der nutzungsbasierten Abrechnungen bezahlen Anwender nur für ihren tatsächlichen Verbrauch.

Ready to get started?

Getting started is easy. Sign up today for a live demo or check out one of our whitepapers on this topic.

Top 6 reasons to Modernize Legacy Middleware

Join us for a live demo on modernizing your messaging workloads

Compare Confluent to Traditional Middleware

Messaging Integration with Confluent

Why Customers Love Confluent

Weitere Ressourcen

Hier findet man ähnliche Ressourcen, um mehr über Messaging-Systeme, Echtzeit-Daten-Streaming und -Analysen, Event-Verarbeitung und die Funktionsweise von Confluent zu erfahren

Blogs und Case Studies

- Messaging-Modernisierung mit Confluent

- Messaging als zentrale Datenquelle („Single Source of Truth“)

- Benchmarking von Messaging-Systemen – Welches ist am schnellsten?

- Erfahren Sie mehr über die Vorteile einer ereignisorientierten Architektur

- Amyway beschleunigt mit Confluent die Messaging-Modernisierung

- Rodan+Fields wechselt mit Confluent von batchorientierten Daten zu Data in Motion

Whitepaper und Demos

- Die wichtigsten 6 Gründe für die Modernisierung veralteter Middleware

- Vergleich zwischen Confluent und traditioneller Middleware

- Wie lässt sich Confluent mit Messaging-Middleware integrieren?

- Demo: Die Entwicklung von Messaging hin zu Data in Motion

- Datenblatt: Die Entwicklung von Messaging hin zu Data in Motion

Webinare und Dokumentation

- Webinar: Modernisierung von Messaging-Workloads mit Daten-Streaming

- Webinar: So transformierte die UC San Diego das Universitätssystem durch Echtzeitdaten

- Webinar: Die richtigen Teile an der richtigen Stelle: Unternehmenstransformation dank Echtzeitdaten bei Advance Auto Parts

- Was ist Confluent Cloud?

- Kafka Streams: Developer Guide

- Erstellung von Daten-Pipelines