[Webinar] Master Apache Kafka Fundamentals with Confluent | Register Here

Anwendungsfall | CDC-Pipelines

CDC-Pipelines mit Apache Flink® erstellen

Change Data Capture (CDC) wird genutzt, um Daten zwischen relationalen Datenbanken zu kopieren und ermöglicht wichtige Backend-Vorgänge wie Datensynchronisierung, Migration und Notfallwiederherstellung. Mit der Stream-Verarbeitung können Change Data Capture-Pipelines erstellt werden, die Event-getriebene Anwendungen und zuverlässige Datenprodukte ermöglichen, mit aktuellen, verarbeiteten Daten, die in ältere und moderne, verteilte Systeme integriert sind.

Jetzt erfahren, wie Confluent Apache Kafka® und Apache Flink® zusammenführt, um Streaming-CDC-Pipelines zu erstellen und Downstream-Analysen mit aktuellen, qualitativ hochwertigen Betriebsdaten zu versorgen.

Von Entscheidungen auf Basis veralteter Daten zu Reaktionen in Echtzeit

Verarbeitungskosten um 30 % reduzieren

Zuverlässige und bereinigte Daten bereitstellen, ohne manuellen Break-Fix-Aufwand

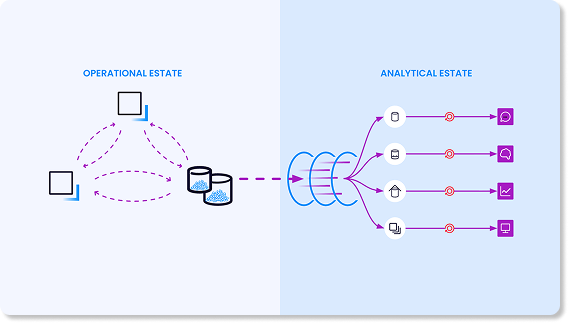

3 zentrale Herausforderungen

bei traditionellen CDC-Architekturen

Die meisten Unternehmen nutzen bereits logbasierte Change Data Capture, um Datenbankänderungen in Events umzuwandeln.

- Signifikante Datenlatenz bei der Batch-Verarbeitung. Anstelle von Event-Streams verlassen sich die meisten Unternehmen auf die Batch-Verarbeitung, um Logdaten downstream zu materialisieren. Dies bedeutet, dass die Datensysteme über Stunden oder Tage hinweg nicht synchronisiert sind, bis der nächste Batch-Prozess ausgeführt wird.

- Kosten für redundante Verarbeitung. Die zusätzlichen Kosten entstehen sowohl durch den Aufbau und die Wartung von Punkt-zu-Punkt-Integrationen als auch durch die redundante Verarbeitung, die über diese Pipelines hinweg stattfindet.

- Vertrauensverlust durch ständige manuelle Reparaturzyklen. Die Aufrechterhaltung der Zuverlässigkeit in all diesen Pipelines ist zeitaufwendig und anfällig für menschliche Fehler. Und dieser Ansatz zwingt die Teams dazu, reaktiv Probleme zu beheben, die erst dann erkannt werden, wenn sie einen anderen nachgelagerten Consumer betreffen.

Durch den Aufbau von CDC-Pipelines mit Kafka und Flink können CDC-Workloads und Batch-Analysen vereinheitlicht und Verarbeitungssilos beseitigt werden. Anstatt auf die Batch-Verarbeitung zu warten und die Kosten für redundante Verarbeitung zu tragen, oder sich auf anfällige Pipelines zu verlassen, ermöglicht diese Architektur:

- Change-Data-Capture-Daten als Event-Streams zu erfassen

- Flink zu nutzen, um diese Streams in Echtzeit zu verarbeiten

- Change-Data-Capture-Streams umgehend in operativen und analytischen Umgebungen darzustellen.

Daten-Value maximieren zu einem Bruchteil der Kosten

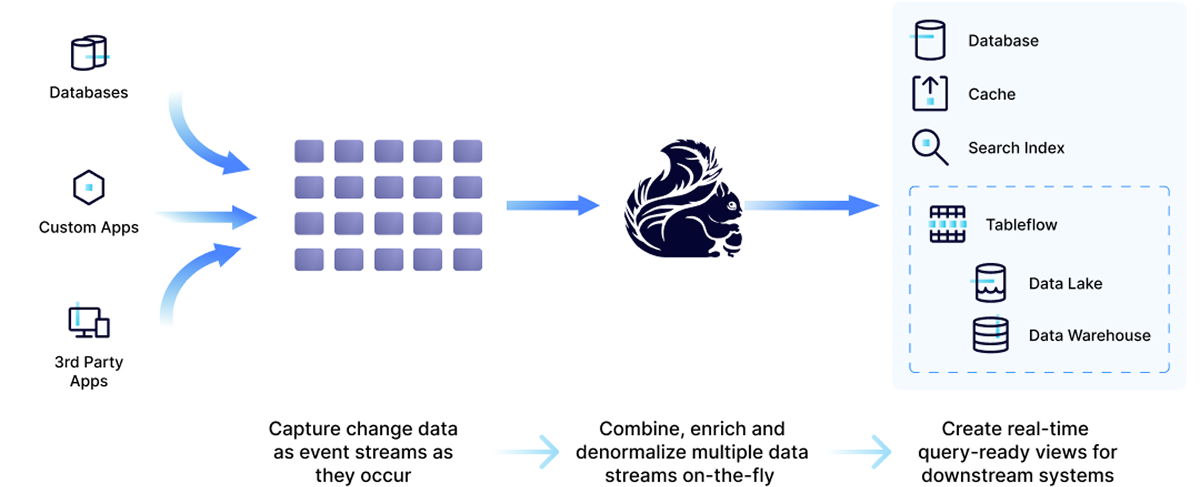

Mit serverlosem Apache Flink® auf der Daten-Streaming-Plattform von Confluent kann die Verarbeitung nach links verlagert werden – vor der Dateneinspeisung –, um Latenzen, die Datenportabilität sowie die Kosteneffizienz zu verbessern.

- Datenanreicherung: Daten mit zusätzlichem Kontext anreichern, um die Genauigkeit zu erhöhen.

- Wiederverwendbarkeit von Daten: Konsistente Datenströme zwischen Anwendungen weitergeben.

- Echtzeit überall: Anwendungen mit niedriger Latenz ermöglichen, sofort auf Events zu reagieren.

- Kosten senken: Ressourcennutzung optimieren und redundante Verarbeitung reduzieren.

AppDev-Teams können Daten-Pipelines erstellen, die rechtzeitiges Handeln ermöglichen

Ob für einen Shift-Left-Ansatz bei der Data-Warehouse- und Data-Lake-Einspeisung für Analysen, die Erstellung von Suchindizes in Echtzeit, ML-Pipelines oder SIEM-Optimierung.

Analytics-Teams können Daten vorbereiten und aufbereiten, um Event-getriebene Anwendungen zu versorgen, indem sie Berechnungen, Statusaktualisierungen oder externe Aktionen triggern

Dazu gehören Anwendungen für GenAI-Lösungen, Betrugserkennung, Echtzeit-Alerts und -Benachrichtigungen, Marketing-Personalisierung und vieles mehr.

3 Schritte zum Aufbau von CDC-Pipelines mit Confluent Stream-Verarbeitung

Mit Confluent können CDC-Streams verarbeitet werden, bevor sie in der Analyseumgebung dargestellt werden. Einfach mit Flink SQ die in Kafka-Topics erfassten Änderungsdaten filtern, zusammenführen und anreichern. Anschließend können Datenströme sowohl in den operativen als auch in den analytischen Umgebungen dargestellt werden.

Streaming-CDC-Demos & Case Studies

Confluent-Kunden nutzen Flink, um bestehende CDC-Anwendungsfälle wie Datensynchronisierung und Disaster Recovery zu verbessern und neue Echtzeitfähigkeiten zu erschließen.

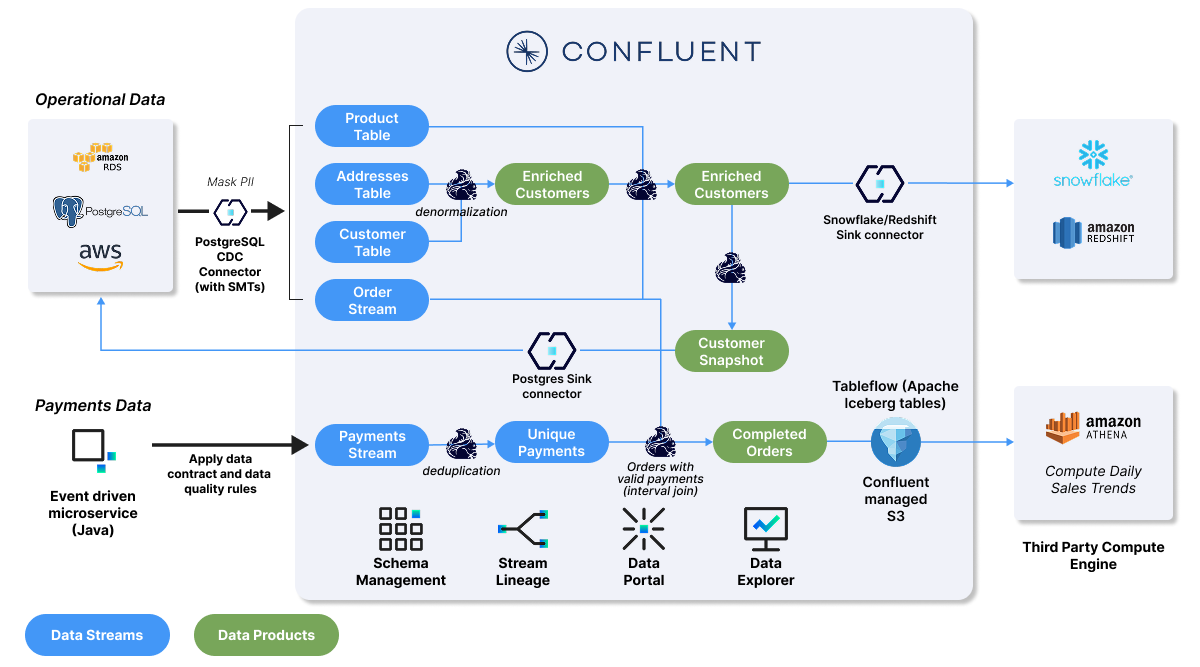

Jetzt im GitHub-Repo erfahren, wie Echtzeitanalysen für Customer 360, Vertriebsanalysen oder Sales-Trend-Analysen implementiert werden können.

Es stehen zwei Labs zu Verfügung:

Lab zu Produktvertrieb- und Customer360-Aggregation

Produktverkaufsdaten bereinigen und aggregieren, die angereicherten Daten in Snowflake oder Redshift importieren und anschließend ein Datenprodukt erstellen, das von operativen Datenbanken genutzt werden kann.

Lab zu täglichen Vertriebstrends

Zahlungen validieren, Verkaufsmuster analysieren, um tägliche Trends zu identifizieren, und anschließend das Kafka-Topic als Iceberg-Tabelle in Amazon Athena darstellen, um tiefere Einblicke zu gewinnen.

„Die Einführung von CDC hat uns ermöglicht, das Potenzial von Echtzeitdaten auszuschöpfen und letztendlich von Batch-Daten-Workloads auf Stream-Verarbeitung umzustellen.“

„Mit Flink haben wir jetzt die Möglichkeit, die Verarbeitung nach links zu verschieben und viele Datentransformationen und Rechenvorgänge an unseren Daten frühzeitig durchzuführen, bevor sie Snowflake erreichen. Dies wird unsere Datenverarbeitungskosten optimieren, um die Menge der uns zur Verfügung stehenden Daten erhöhen können.“

„Mit Confluent können wir jetzt ganz einfach die CDC-Pipelines erstellen, die wir benötigen, um Daten in Echtzeit zu erfassen, anstatt sie alle 10 Minuten in der Batch-Verarbeitung abzurufen, so dass wir Betrug schnell erkennen können.“

„Die größte Herausforderung bestand darin, dass wir nicht über ausreichende interne Ressourcen verfügten, um CDC und den Streaming-Prozess zu entwickeln. Nun können wir problemlos CDC-Systeme erstellen und das Entwicklerteam konnte während der Entwicklung des Streaming-Prozesses seine Arbeitsbelastung reduzieren.“

“Mit Confluent Cloud können wir jetzt jedem Team operative Daten in Echtzeit zur Verfügung stellen. Das ist wirklich effektiv und reduziert unseren operativen Aufwand erheblich.”

Bereit, CDC-Daten in Echtzeit mit Flink zu verarbeiten? Mit Confluent loslegen und eine Stream-Verarbeitung implementieren, die für jede Umgebung geeignet ist.

Confluent Cloud für Apache Flink® testen—verfügbar auf AWS, Google Cloud, Microsoft Azure—um Anwendungen mithilfe von Kafka + Flink mit serverloser, Cloud-nativer Kosteneffizienz und Einfachheit zu entwickeln.

Und mit Confluent Platform für Apache Flink® können bestehende Flink-Workloads auf einer selbstverwalteten Daten-Streaming-Plattform genutzt werden, die lokal oder in einer privaten Cloud bereitgestellt werden kann.

Confluent Cloud

Ein vollständig verwalteter cloud-nativer Service für Apache Kafka®

Streaming CDC With Flink | FAQs

How does a streaming approach improve on batch ELT/ETL pipelines?

A streaming approach allows you to "shift left," processing and governing data closer to the source. Instead of running separate, costly ELT jobs in multiple downstream systems, you process the data once in-stream with Flink to create a single, reusable, high-quality data product. This improves data quality, reduces overall processing costs and risks, and gets trustworthy data to your teams faster.

Why use Apache Flink® for processing real-time CDC Data?

Apache Flink® is the de facto standard for stateful stream processing, designed for high-performance, low-latency workloads—making it ideal for CDC. Its ability to handle stateful computations allows it to accurately interpret streams of inserts, updates, and deletes to maintain a correct, materialized view of data over time. Confluent offers a fully managed, serverless Flink service that removes the operational burden of self-management.

How do you handle data consistency and quality in real-time CDC pipeline?

Data consistency is maintained by processing CDC events in-flight to filter duplicates, join streams for enrichment, and aggregate data correctly before it reaches any downstream system. Confluent's platform integrates Flink with Stream Governance, including Schema Registry, to define and enforce universal data standards, ensuring data compatibility, quality, and lineage tracking across your organization.

How does Confluent Cloud handle changes to the source database schema?

When your CDC pipeline is integrated with Confluent Schema Registry, it can automatically and safely handle schema evolution. This ensures that changes to the source table structure—like adding or removing columns—do not break downstream applications or data integrity. The platform manages schema compatibility, allowing your data streams to evolve seamlessly.

What are the main benefits of using a Fully managed service for Apache Flink® like Confluent Cloud?

A fully managed service eliminates the significant operational complexity, steep learning curve, and high in-house support costs associated with self-managing Apache Flink®. With Confluent, you get a serverless experience with elastic scalability, automated updates, and pay-as-you-go pricing, allowing your developers to focus on building applications rather than managing infrastructure. In addition, native integration between Apache Kafka® and Apache Flink® and pre-built connectors allow teams to build and scale fast.

How does Confluent Cloud simplify processing Debezium CDC events?

Confluent Cloud provides first-class support for Debezium, an open source distributed platform for change data capture. Pre-built connectors can automatically interpret the complex structure of Debezium CDC event streams, simplifying the process of integrating with Kafka and Flink.