[Webinar] Master Apache Kafka Fundamentals with Confluent | Register Here

Confluent für Digital-Native-Unternehmen

Für Unternehmen, die Apache Kafka® bereits einsetzen, um Events in Echtzeit optimal zu nutzen, Innovationen schnell und flexibel voranzutreiben und neue digitale Produkte schneller auf den Markt zu bringen.

Confluent bietet das beste Kafka-Erlebnis, sowohl vor On-prem als auch in der Cloud, mit vereinfachtem Management aufgrund operativer Resilienz, um die Gesamtbetriebskosten zu senken und mehr mit der Daten-Streaming-Plattform zu erreichen.

Warum Confluent

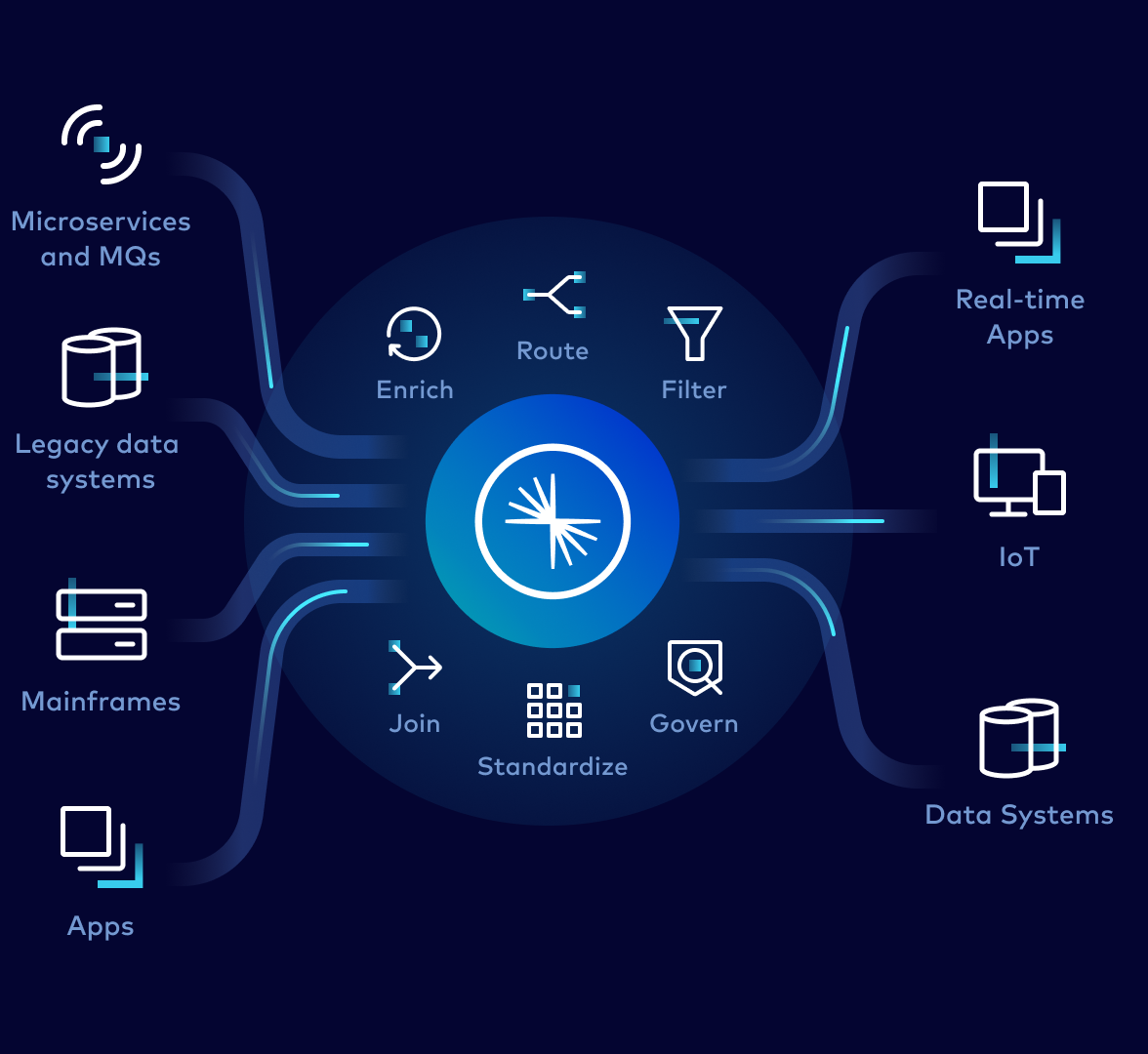

Eine flexible und skalierbare Datengrundlage auf Streaming-Basis macht Datenprodukte kontinuierlich und in Echtzeit interoperabel, egal für welchen Anwendungsfall.

Wiederverwendbare Datenprodukte erstellen

Daten von überall aus mit einer entkoppelten, unveränderlichen Event-getriebenen Architektur und In-Stream-Verarbeitung kombinieren

Jeden Workload problemlos bewältigen

Einfache Skalierung für die mühelose Verarbeitung von Billionen von Messages pro Tag, ohne die Performance oder Uptime zu beeinträchtigen

Dateninkonsistenzen beseitigen

Data Contracts verwalten, Duplikate verhindern und Konsistenz ohne Datenverlust garantieren

KI-Fähigkeiten aufbauen

ML-Modelle mit kontinuierlich fließenden Echtzeitdaten trainieren, damit Anwendungen auf jedes Event kontextsensitiv und intelligent reagieren können

Daten End-to-End verwalten

Die einzige vollständig verwaltete Governance-Suite für Apache Kafka ermöglicht es, Datenströme schneller weiterzugeben und gleichzeitig die Integrität und Sicherheit der Daten zu gewährleisten.

Wie Confluent das ultimative Kafka-Erlebnis liefert

Zeit und Geld sparen. Zukunftssicher global expandieren. Mehr aus Kafka herausholen.

Gesamtbetriebskosten um bis zu 60 % reduzieren

Kostenlos starten und nutzungsbasiert für Kafka bezahlen sowie nach Bedarf flexibel hoch- und runterskalieren. Kafka für jedes Budget und für jeden Anwendungsfall anpassen, mit Scale-to-Zero-Pricing.

Für einen zuverlässigen und effizienten Betrieb sorgen

Die Bereitstellung von selbstverwalteten Confluent Clustern automatisieren. Ausfallzeiten und Datenverluste minimieren, indem Probleme gelöst werden, bevor sie auftreten und mit einer 99,99 %igen Uptime.

Globale Skalierung? Kein Problem!

Dank Confluent können Event Streams nahtlos und sicher zwischen unterschiedlichen, global verteilten Clustern ausgetauscht werden. Skaliert werden kann nach oben und unten - so werden Anforderungen an regionale Workloads problemlos erfüllt. Zudem können Daten über lokale und Multi-Cloud-Implementierungen hinweg repliziert werden.

Die Strategie ist „Cloud-first“, nicht „Cloud-only�“

Daten über alle Deployments hinweg zusammenführen. Nahtlos eine persistente Brücke zwischen lokalen Umgebungen und der Cloud bzw. auch zwischen verschiedenen Clouds errichten. Zudem ist es möglich, Punkt-zu-Punkt-Verbindungen zu eliminieren und Verbindungen zu Cloud-Datensystemen herzustellen, um innovative Cloud-native Anwendungen schneller zu entwickeln.

Multi-Layer Sicherheit und Compliance

Granulare Zugriffskontrollen und Echtzeit-Monitoring bieten robuste Sicherheit und Compliance-Schutzmaßnahmen vor unbefugtem Zugriff und Sicherheitsverletzungen für die Daten. Zuverlässiges Streamen mit globalem Datenschutz- und regulatorischer Compliance.

Fully Managed über alle Clouds hinweg

Mit nur wenigen Klicks in jeder Cloud bereitstellen und Cloud-Implementierungen automatisch dimensionieren, skalieren, aktualisieren und betreiben. Vereinfachter Beschaffungsprozess für Confluent Cloud mit direktem Zugriff über die Cloud-Marketplaces.

Skalierbarkeit für wachsende Bedürfnisse

Im kleinen Rahmen starten, ohne auf robuste Funktionen zu verzichten, die für eine spätere Skalierung des Unternehmenswachstums notwendig sind. Durch automatische Optimierung der Datenplatzierung wird für einen Lastausgleich gesorgt und der größte Engpass von Kafka beseitigt: Apache ZooKeeper.

Daten zeitlich unbegrenzt aufbewahren

Alle Events so lange speichern wie gewünscht und nur für den tatsächlich genutzten Speicher zahlen. Datenkompatibilität mit Schema Registry gewährleisten und mit Schema-Validierung Datenintegrität durchsetzen. Mühelose Skalierung von null auf 1 PB. Tiered Storage senkt die Speicherkosten um bis zu 70 %.

Streaming-Anwendungen schneller entwickeln

Eine erhöhte Entwicklungsgeschwindigkeit ermöglicht die schnellere Umsetzung neuer Streaming-Anwendungen. Im Confluent-Ökosystem stehen vorgefertigte, von Experten entwickelte Connectors zur Verfügung, die zum Kombinieren von Daten in Kafka mit Drittanbieter-Systemen für eine Vielzahl von Anwendungsfällen eingesetzt werden können.